「人は見たいように見る」これはローマの軍人・政治家カエサルが残した名言だ。まさに人間の本質を表す言葉であり、これは現代の人間にも同じことが言える。

現在、「人は見たいように見る」傾向は科学的に研究されており、認知心理学において「確証バイアス」と呼ばれている。

確証バイアスとは、自分の意見が正しいことを補強するような情報や、価値観に沿った情報ばかりを集め、意見に反する情報を無視してしまう傾向のことだ。様々なところで、この確証バイアスによる問題は起きているが、現代では特に、インターネット上における確証バイアスを強化する「フィルターバブル」が問題視されている。

情報過多だからこそ起こるパラドックス

フィルターバブルとは、バイラルメディア「アップワージー」のCEOであるEli Pariser氏が、著書『フィルターバブルーインターネットが隠していること』の中で提唱した概念だ。

検索サイトやソーシャルメディアのアルゴリズムは、ユーザーのクリック・検索履歴に基づいてユーザーが好む情報を優先的に表示している。

ユーザーの好む情報が優先的に表示される傾向が強まると、ユーザーが自分の思想や価値観に沿った情報だけを目にする環境が作られる。その結果、ユーザーは自分の思想や価値観の皮膜(バブル)の中だけに留まってしまう。そのような状態をフィルターバブルと呼ぶ。

ーEli Pariser氏 TED YouTubeより

そもそもなぜアルゴリズムによるフィルタリングが必要なのか。大量の情報が存在する中、ユーザーはすべての情報にアクセスすることは不可能だ。

そこでアルゴリズムで情報をフィルタリングし、ユーザーにとって最適な情報を届けることで、ユーザーの満足度が上がる。高性能なフィルタリングは、FacebookやGoogleなどのプラットフォームの価値であるとも言えるだろう。

ユーザーの満足度向上を追及し、ユーザー好みの情報を優先的に表示する。それが結果として、フィルターバブルを引き起こしてしまうという非常に皮肉的な問題である。

米国大統領選で認識されたフィルターバブル

2016年米国大統領選において、このフィルターバブルは非常に注目を浴びた。

トランプ氏支持の保守派な人々には、トランプ氏を支持する投稿ばかりがFacebookのフィードに表示された。しかし保守派の人々のフィードに、反対のクリントン氏を支持する投稿は表示されなかった。この事実に多くの人が気づいたのだ。

それはクリントン氏を支持するリベラル派の人々にしても同様だ。トランプ氏を支持するブログ記事「 “Why I’m Voting For Donald Trump」は、Facebook上で150万件以上シェアされた。

しかし、クリントン氏を支持するリベラル派の経営者Mostafa M. ElBermawy氏は、選挙期間中一度もそのブログ記事をFacebookフィードで目にすることがなかった。また、彼のリベラル派の知人も同様に、選挙期間中に当ブログ記事をFacebookフィードで目にしなかった、とWIREDで証言している。これにはFacebookのアルゴリズムが寄与している。

2016年の米国大統領選で、保守派・リベラル派それぞれの支持者が、自分の思想の皮膜(バブル)の中に留まることになった。このように、偏った思想を先鋭化させること、つまりフィルターバブルの促進を、意図的ではないにせよFacebookが助長したのではないかとの声が上がった。

これに対しFacebookは、科学誌「サイエンス」に論文「Exposure to ideologically diverse news and opinion on Facebook」を掲載。Facebookはこの論文の中で、自社の持つアルゴリズムがフィルターバブルの原因になってはいないと主張。

2014年7月から2015年1月までの半年間、ユーザーがFacebookでシェアしたリンクから22万6,000件のハードニュース(ジャーナリストが執筆したニュース)を選択。リンクのシェア数38億回、表示回数9億回、クリック数5,900万回が、どのような経路で起こったのかを分析した。Facebookの行った調査は以下の通りだ。

2014年7月から2015年1月までの半年間、ユーザーがFacebookでシェアしたリンクから22万6,000件のハードニュース(ジャーナリストが執筆したニュース)を選択。何を基に、ユーザーがハードニュースに対するアクションをしたのか(リンクのシェア数38億回、表示回数9億回、クリック数5,900万回)を分析した。

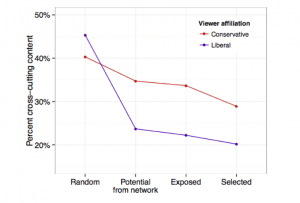

Exposure to ideologically diverse news and opinion on Facebookより

まず、リベラル派と保守派のユーザーが、反対の立場のニュース(リベラル派は保守派のニュースを、保守派はリベラル派のニュースを)に接する割合を以下の4つのパターンで分類した。

1.ランダムで表示されるニュース

2.友達によるシェアで表示されるニュース

3.Facebookのアルゴリズムによってフィードに表示されたニュース

4.表示されたリンクに対してユーザーが自発的にクリックしたニュース

その結果は以下の通りだ。

1.ランダムで表示されるニュース

リベラル派は表示されるニュースのうち、45%が反対派のニュース。

保守派は表示されるニュースのうち、40%が反対派のニュース。

2.友達によるシェアで表示されるニュース

リベラル派は表示されるニュースのうち、24%が反対派のニュース。

保守派は表示されるニュースのうち、35%が反対派のニュース。

3.Facebookのアルゴリズムによってフィードに表示されたニュース

リベラル派は表示されるニュースのうち、22%が反対派のニュース。

保守派は表示されるニュースのうち、33%が反対派のニュース。

4.表示されたリンクに対してユーザーが自発的にクリックしたニュース

リベラル派は表示されるニュースのうち、20%が反対派のニュース。

保守派は表示されるニュースのうち、29%が反対派のニュース。

以上の結果を元に、Facebookはアルゴリズムがフィルターバブルの直接的な原因になっているわけではないと主張した。

フィルターバブル解決に向けた取り組み

Pew Research Centerの調査によると、2016年5月当時、米国成人の44%がFacebookでニュースを収集しているという結果が出ている。Facebookはもはやソーシャルメディアとしての機能のみならず、ユーザーにとってニュースメディアとしての機能も果たしている。ニュースメディアとしての情報伝達を担うため、Facebookは偏りのない情報を提供することが求められる。

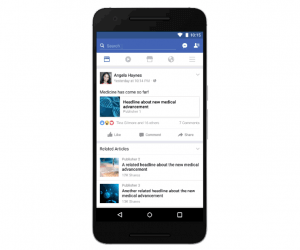

Facebookは2017年4月から、フィードのニュース記事の下に、異なるメディアの異なる視点の関連記事を表示する取り組みを開始している。これは、Facebookのアルゴリズムがフィルターバブルを助長しているという批判に対して講じた策だ。

また、その他にもフィルターバブルを破るための取り組みはある。例えば、英国のリベラル系メディア、ガーディアンは「Burst your bubble」(バブルを破れ)という新コーナーを設立。リベラル系メディアにありながら、当コーナー内で保守派の論調を紹介している。

異なる思想、価値観の人々の交流を促し、断絶を生じさせないようにする。フィルターバブルを解決するための取り組みは、様々なところで始まっている。